Конференции — странная штука. Вроде бы ходишь, отвечаешь на вопросы по своим проектам и планам, слушаешь что и как другие собираются делать, знакомишься и развиртуализируешься — в общем, весело проводишь время, в чем тут продуктивность — непонятно =) А потом приходишь домой, поспишь, мозг всю инфу дообработает — и бинго! К примеру, у меня планы были прям очень размытые, по многим направлениям, и чоткого-чоткого не было. Но я раз 15 отвечал о том, что вижу перспективу в бурж дорах (хотя сам же до этого считал, что слишком геморно их создавать), прослушал несколько докладов и личных впечатлениях от подобной работой, что уже сам начал задумываться — схерали я их не делаю оптом, а пытаюсь какие-то другие пилить.

Лирическое отступление — опять же, слушая доклады и восстанавливая старые истории, начал приходить к выводу — что вся соль в масштабировании. Создать 100 мелких проектов, каждый из которых в среднем что-то приносит, и получить профит — куда эффективней, чем создать ручками один проект и надеятся. И вся соль именно в автоматизации, делегирование, выстраивании процессов и т.д., и ниша тут вообще побоку. И очень многие топчики занимались именно этим — создавали сотнями статейники, покупали сотнями сайты, делали сотни-тысячи доров, и т.д — и уже потом переходили к крупным проектам. Тот, кто сделал 5-10 малостраничников и успокоился — заработали свои 50-100к рублей и все. Тот, кто сделал 300-500 малостраничников, пусть даже в среднем менее доходные — получили куда более существенный профит. И опять, ключевая способность — это делегирование, ибо ручками в одно лицо делать в случае масштабной работы — нереально, и быстро выгораешь (кто пробовал — тот знает). Оно может и не взлететь, разумеется — но если ничего не делать, то оно гарантированно не взлетит. Ну и не обязательно это именно 100 проектов — это может быть просто 10.000 статей например. И не обязательно серые проекты — белые тоже. Конец лирического отступления.

#smartconf2019, Микола, Алексеич

Так вот. Подумал я над всем этим, и решил — надо бы хоть небольшую сеточку сделать, а то несолидно как-то) Рабочий пример есть, через три месяца 100 уников в сутки, через полгода — 1к уников (дальше пока стопорится), доход $1 с килоуника в адсенсе, еще какую-то копеечку думаю с пушей можно будет получить. Емкость ниши — еще внукам хватит. Яндекса с его придирками нет, РКНа нет. Только Google, DMCA и баны в адсенсе =) 10 — несолидно, можно и ручками сделать, 1.000 — слишком много и затратно (одни домены сколько стоят..), а вот 100 в самый раз. Тут с одной стороны и затраты терпимые (не разорят, если все зафакапится), и профит в случае успеха ощутимый.

А что у нас там с рискам?

- Блокировка монетизации через адсенс — но остаются пуши, а раз доры — то и всякие попапы-кликандеры накрайняк

- Баны от гугла — гарантированно придут (это ж доры), но по факту аналогичные сайты живут годами

- Не будет трафа — ну сорян, бывает, вернемся на завод =)

- Абузы — DMCA достаточно мягко работает, регистратор-хостинг — абузоустойчивые

- Заблокируют core-функционал — пока что предпосылок нет, и есть альтернативы с более низким качеством

Но есть разумеется и подводные камни, иначе этим бы занимался каждый, не правда ли =) В отличие от малостраничников, которые делаются копирайтерами и с текстовым контентом, и дорами, которые генерятся на автомате доргенами — здесь все несколько сложнее. На первые доры у меня ушло недели эдак две на то, чтобы все отладить и сгенерить сайты. И если по затратам каждый дор будет стоить несколько часов работы программиста — то он никогда не окупится.

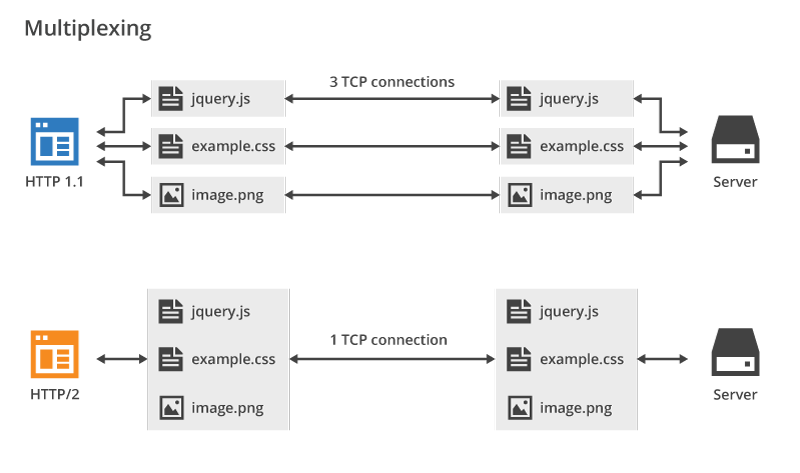

Решение — раздробление задач и написание ПО, которое позволит просто толковому человеку (не программисту) создавать подобные сайты, а уж бекенд будет всю тяжелую работу делать. Ну и выкладывать сайт — тоже любой вебмастер справится по чек-листу. Опять же, написание такого ПО для создания 10 сайтов — нерентабельно. Для 100 сайтов — было бы нерентабельно, если бы я делегировал кодинг (а может и нет, но это однозначно затянет сроки, а этого бы не хотелось). Но оправданно, если я сам под себя напишу, отлажу, сгенерю первые 10 сайтов, пропишу все инструкции — и дальше уже просто подкидывать людей в систему, чтобы они делали что 30 сайтов в месяц, что 30 сайтов в день.

Сначала я прикинул, что стоимость сайта обойдется примерно в $100, плюс домен, и такую оборотку я не вывезу, надо будет искать инвестора/кредиты, и прочие сложности (оно конечно интересно всем этим заниматься, но это отдаляет от результата). Но потом подумал, что каждая дополнительная неделя кодинга будет уменьшать данную сумму вдвое, упрощая процесс (совсем его автоматизировать можно, но тогда качество сайтов существенно упадет). По ходу работ конечно видно будет, но мне кажется будет вполне реально уменьшить затраты до $30 на сайт вместе с доменом, что позволяет делать их на свои с достаточной скоростью. Тут в плюс еще и то, что достаточно много кода я уже сам написал, и мне проще будет разобраться.

Serega Kraev, Михаил Шакин

Итого — месяц кодинга, месяц отладки и создания 10 доров самому с написанием инструкций, 3 месяца по 30 доров в месяц, и месяц на всякий случай. К сентябрю сеточка должна быть закончена, а так же будет видно, начали ли первые сайты давать первый траф — и надо либо останавливать конвейер, или дальше пилить/увеличивать обороты.

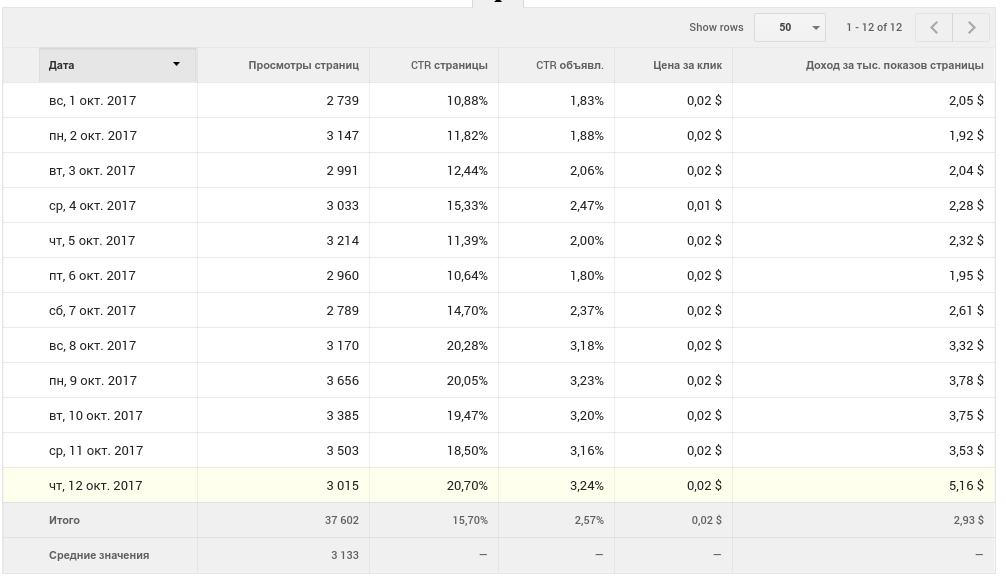

Расчеты профита простые — через полгода 1к уников на сайте, с монетизацией $1 с килоуника, 100 сайтов * 1к * 1$ = $100/день. Если мои влажные фантазии не оправдаются и на всю катушку сработает один из рисков — то я потеряю месяц на кодинг, и около $3.000 — то есть ниочем, я на кодеропроектах и неудачных покупках сайтов просрал гораздо больше. При этом ROI будет 100% в месяц (три раза ха) — то есть даже если я в 10 раз переоцениваю эффективность, все равно это будет выгодно. Зато научусь делегировать подобные задачи, управляться с сотней сайтов (сейчас у меня их всего 30 — и я только сейчас узнал с доклада Шакина, что есть сервисы для управления WP-сайтами с одного дашборда), какие тут возникают проблемы, как их можно решать, какой продукт можно для этого запилить и т.д. Если оправдаются — то получаем хороший буст по заработку, раскочегариваем конвейер на 1.000 сайтов, начинаем приторговывать сайтами на телдери, продаем софт, пилим инфокурс, отращиваем ЧСВ, рассказываем на серьезных щщах про успешный успех — ну то есть все как всегда =)

Тут можно было бы написать чуть подробней, что за ниша и какие тонкости — но нафига?) Я же не продаю все это кому-то и не завлекаю в нишу, её и так уже пара человек пылесосят и продают обучение с софтом. Отчетики как всегда в итогах месяца, кому интересно — можете до августа 2018-го промотать, когда я начал ими заниматься.