Поездка до дома оказалась тем еще приключением.. 30 часовой перелет с тремя пересадками, в том числе один трансатлантический (10 часов в самолете, а кондоровцы за просмотр фильмов с медиацентра требовали 10 евро, не то что иберия). Суммарно получилось все 60 часов без сна, так как вылет тоже посреди ночи, не поспишь. В Пунта-Кане, Доминикане, оказалось дофига русских (не зря сюда чартеры возят пактеников), а аэропорт оказался самым забавным — все гейты и часть залов ожиданий накрыты соломенными крышами:

Нас бекпкеров набралось 11 человек, кто ехал таким замысловатым маршрутом (зато самым дешевым). Половину длинного перелета в итоге проболтал с немкой, живущей в Эдинбурге, переводчицей) А до Москвы рейс оказался полупустым, так что наконец-то удалось три часа поспать. А вот в Москве и начались неприятности — как оказалось, Перу относится к странам с «плохим рейтингом», не говоря уже про мой внешний вид, так что на таможне мне переворошили весь рюкзак (буквально, даже грязное белье), проверили экспресс-тестом на наркотики. В итоге докопались до безобидного, купленного в dute-free чая из листьев коки и каких-то конфет в виде коричневых мягких брусочков — и ладно бы просто изъяли, я спокойно доехал бы до вокзала и упал в поезд. Но нет, бюрократическая машина, и они оформляли этот чай все 3 часа, записывая акты изъятия, взвешивая этот чай и т.д. В итоге опоздал на поезд, пришлось выкупать следующий (сдать предыдущий билет в аэропорту так же возможности нет), еще -3000 рублей. Чай отправили на экспертизу, буду ждать результатов (объем для личного пользования, так что ничего особо серьезного).

Догадайтесь, что сделал на следующее утро штатный милиционер в поезде? Правильно, тоже самое (обычно они просто досматривают по карманам). Люби Россию, блджад! Самое забавное, что оба они досматривают лишь подозрительных граждан — но кто ж доверит перевозку наркоты подозрительным гражданам? Или еще попадаются идиоты с дредами, которые таскают с собой косяки в карманах (потому что даже с этими досмотрами я вполне мог найти 5-10 мест где его заныкать, если бы хотел). Комедия.

Ну да не суть, главное что доехал) Впервые попал в зиму, снег вижу впервые за 4 года — с тех пор как в первый раз уехал в Таиланд.

4-х месячный трип окончен, +3 страны, новый континент. Почти все время в Андах — мне весьма понравилось жить в городах на 1500-2000м. Южная Америка оказалось не такой уж дорогой, как все пугали, и не такой опасной. В целом, трип получился годный, жаль пришлось досрочно заканчивать — при таком курсе рубля деньги исчезают слишком быстро (( Альтернатива для зимовок? Вряд ли. Вариант для иммиграции? Очень даже. Последняя неделя в Перу получилась хороша на треки, хотя в целом страна трешовая (разве что еда лучше):

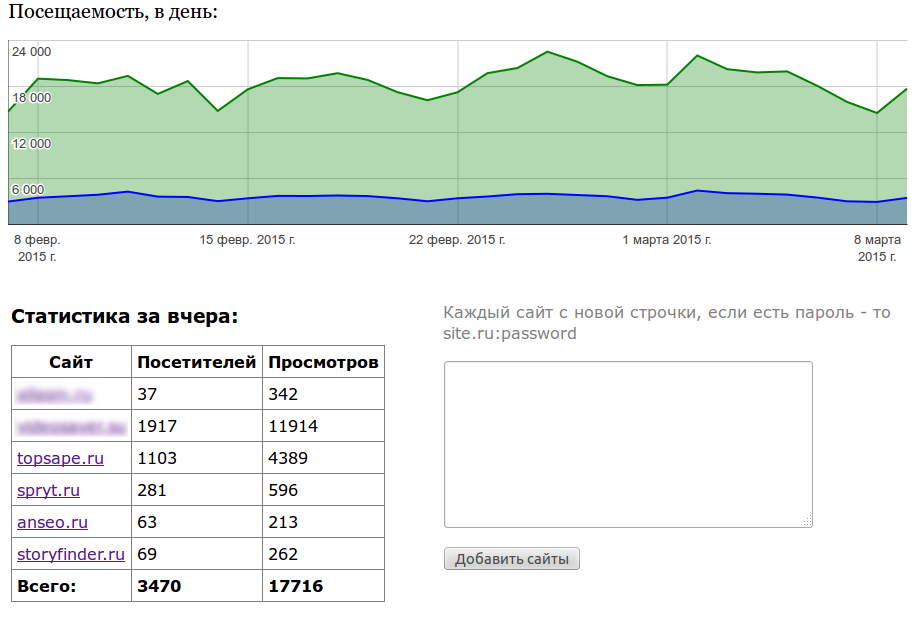

Планы на будущее — отрабатывать долг, реализация пары новых проектов, апгрейд старых. А именно — фриланс (ура, уже есть один небольшой заказ) + с одеском, «пикабу для онямэ» (решил делать на пыхе, ибо буду еще пару месяцев разбираться с монгой, а скрипт мне потом еще понадобится — а может и на продажу пойдет) + бурж sf, коммьюнити вокруг storyfinder + очередная сессия работ над топсапой. Как минимум до мая-июня никуда особо выбираться не буду (разве что по мелочи), так что все пучком.

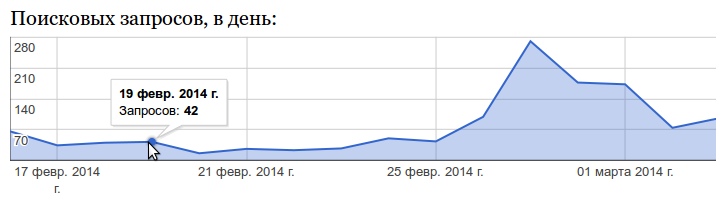

Сегодня впервые сделал 3+ часа продуктивного времени (а сейчас уже все 5) — засел за скрипт для объединении стат нескольких сайтов с LI (мой мелкоскрипт показывал только текущие данные, а монстра вроде LiViewer ставить и тем более платить не хотелось). Например, за последние 30 дней максимальная посещаемость у меня была 2 марта, 4406 посетителей и 22094 просмотра. В итоге получилось что-то вроде этого:

Есть поддержка стат под паролем, БД разумеется не нужна, только файлу sites.dat дать права на запись. Простой как валенок скрипт (это я к тому, что не надо придираться к плохой структуре — я писал в первую очередь для себя и максимально просто и быстро). Подобные этому скрипты (обычно конечно они куда сложнее) я с удовольствием делаю на заказ.

Вот такие новости пока что =) Всем добра!